Artikel zur Veröffentlichung in den Workshops der ICCV

Zusammenfassung. Aktuelle Spitzenreiter in Deep Neural Networks für Bildklassifizierung bestehen aus 10–100 Millionen lernbaren Parametern, d.h. Gewichten. Trotz ihrer hohen Klassifikationsgenauigkeit sind diese Netzwerke stark überparametrisiert. Die Komplexität der Gewichtsanzahl kann als Funktion der Anzahl von Kanälen, der räumlichen Ausdehnung des Inputs und der Anzahl der Schichten des Netzwerks betrachtet werden. Durch die Verwendung von konvolutionären Schichten skaliert die Komplexität der Gewichtung üblicherweise linear in Bezug auf die Auflösungsdimensionen, bleibt jedoch quadratisch in Bezug auf die Anzahl der Kanäle. Aktive Forschung der letzten Jahre bezüglich der Anwendung von Multigitter-inspirierten Ideen in Deep Neural Networks hat gezeigt, dass einerseits eine signifikante Anzahl von Gewichten durch geeignete Gewichtsteilung eingespart werden kann und andererseits eine hierarchische Struktur in der Kanaldimension die Gewichtskomplexität auf linear verbessern kann. Unter Verwendung dieser Erkenntnisse stellen wir eine Architektur vor, die Multigitter-Strukturen in allen relevanten Dimensionen etabliert und einen drastisch verbesserten Genauigkeit-Parameter-Ausgleich bietet. Unsere Experimente zeigen, dass diese strukturierte Reduktion der Gewichtsanzahl die Überparametrisierung reduziert und zusätzlich die Leistung über state-of-the-art ResNet-Architekturen bei typischen Bildklassifikationsbenchmarks verbessert.

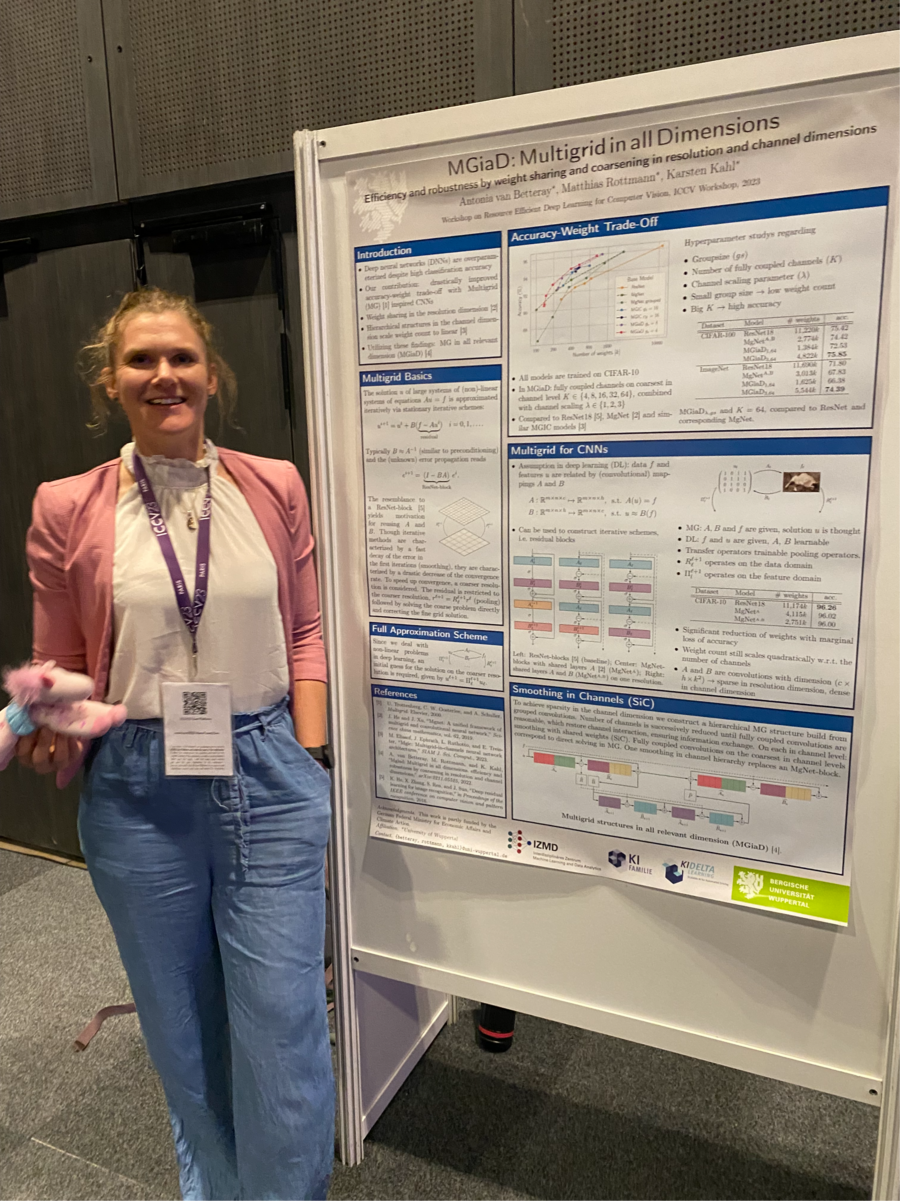

Der Artikel ist hier verfügbar: https://openaccess.thecvf.com/content/ICCV2023W/RCV/papers/van_Betteray_MGiaD_Multigrid_in_all_Dimensions._Efficiency_and_Robustness_by_Weight_ICCVW_2023_paper.pdf